基础架构部文档

基础架构部文件格式标准参考

技术文档

mr_doc 接入ucenter 认证登录

loki日志收集

https证书与ssl/tls 加密

FTP 主动模式和被动模式的区别

Hadoop-windows10安装部署Hadoop2.7.3

JKS和PFX证书文件格式相互转换方法

KVM 基础操作

k8s nginx ingress日志收集到ELK并分析

Django基础

clash http代理 socks代理服务器搭建 配置

Ubuntu 22.04 安装 FFmpeg v7.0

ORM

AI MCP 介绍

Django 模板

Office正版化项目的个人体验和心得

重置jenkins构建历史

K8S实施方案

k8s的yaml文件语法

Docker的优势与虚拟机的区别

问题处理文档

HR推送数据问题处理报

Nginx从入门到放弃01-nginx基础安装

Nginx从入门到放弃02-Nginx基本命令和新建WEB站点

Nginx从入门到放弃03-Nginx调优

Nginx从入门到放弃04-Nginx的N种特别实用示例

JMeter教程

01-mariadb编译安装

02-mariadb二进制安装

Docker修改默认的存储路径

01-influxdb2时序数据库简介及安装

02-influxdb2时序数据库核心概念

03-influxdb2时序数据库flux查询语言

04-influxdb2--Python客户端influxdb-client

05-Spring boot 集成influxdb2

06-influxdb2其他知识

OA添加waf后相关问题的解决过程

排除java应用cpu使用率过高

exsi迁移文档

视频测试

阿里云产品试题

超融合服务器和传统服务器的区别

Serv-U问题集锦

文件夹共享操作手册

磁盘脱机处理方案

Office内存或磁盘空间不足处理方法

Cmd中ping不是内部或外部命令的解决方法

ELK 搭建文档

限制用户的远程桌面会话数量

Docker快速安装rocketmq、redis、zookeeper

超融合建设方案

git 入门

HR系统写入ES数据报错403

ELK搭建文档

KVM 安装和基础使用文档

helm 安装 rancher

访问共享提示禁用当前用户解决方法

K8S StorageClass搭建

KVM 扩展磁盘

借助sasl构建基于AD用户验证的SVN服务器

fastdfs编译安装并迁移数据

关闭系统保护的必要性

SCF 前置机部署

阿里云OSS学习文档

阿里云学习文档-VPC

(k8s踩坑)namespace无法删除

rancher-helm安装

zookeeper集群安装

批量替换K8s secrets 中某个特定域名的tls证书

kibana 批量创建索引模式

centos7 恢复Yum使用

ACP云计算部分知识点总结

Loki 日志系统搭建文档

自动更新k8s集群中所有名称空间中特定证书

AI分享

(AI)函数调用与MCP调用的区别

安装戴尔DELL Optilex 7040 USB驱动时提示无法定位程序输入点 kernel32\.dll

新华三服务器EXSI 显卡直通

conda

双流本地k8s搭建

通义灵码介绍

本文档使用「觅思文档专业版」发布

-

+

首页

超融合建设方案

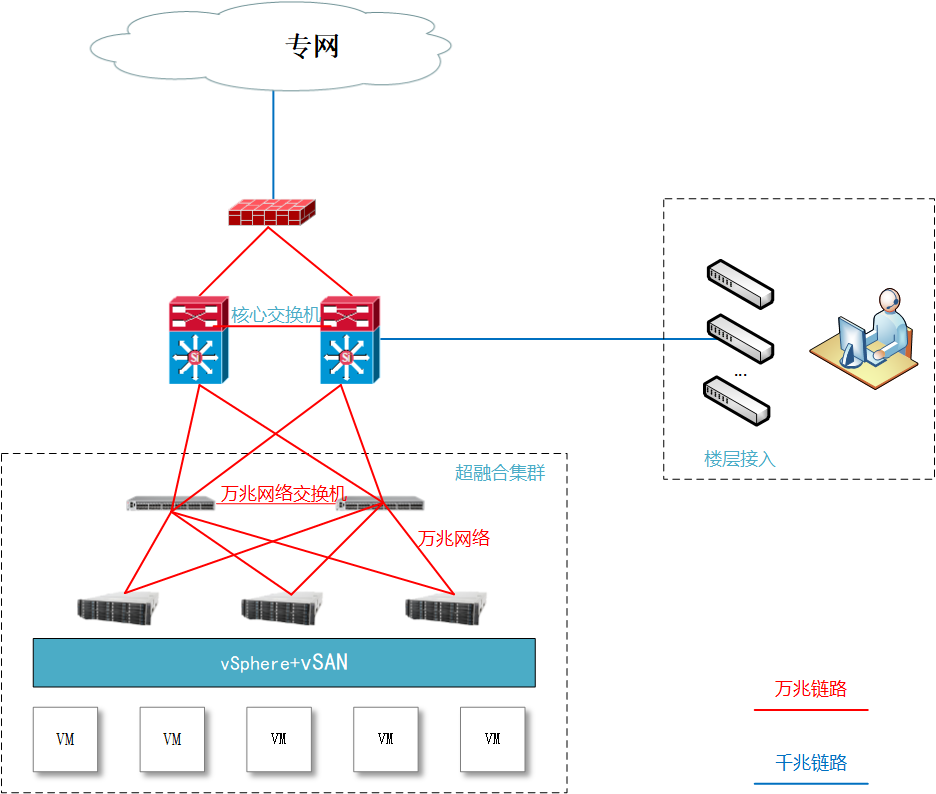

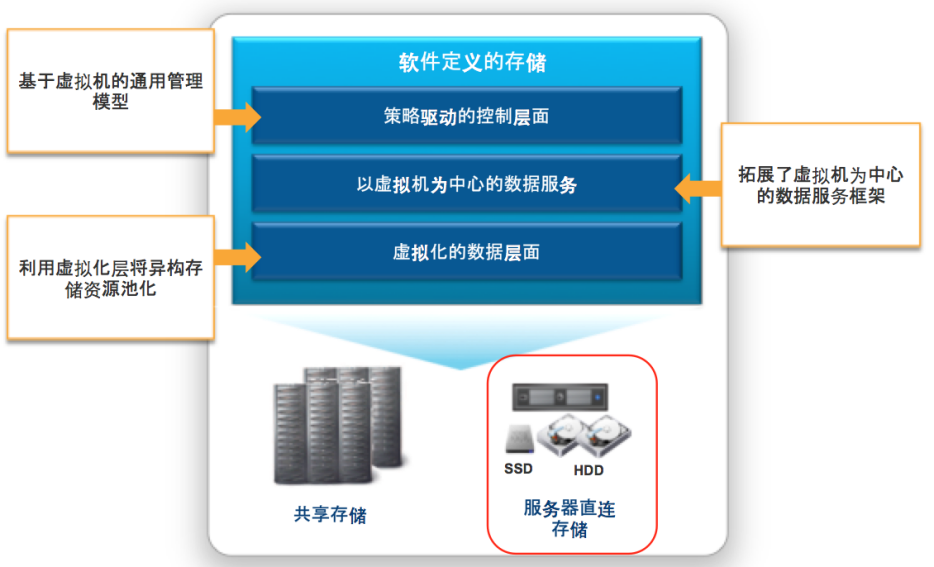

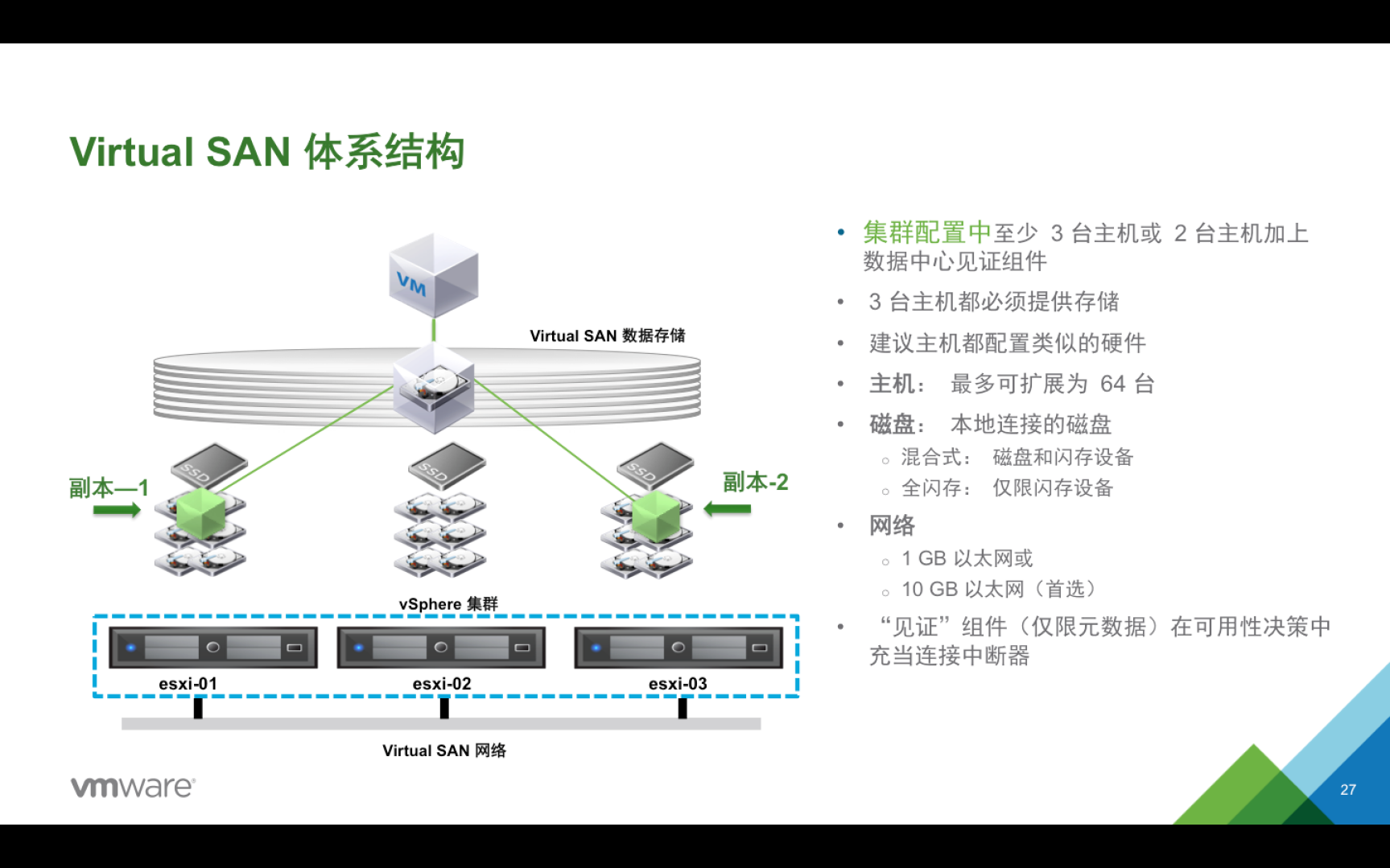

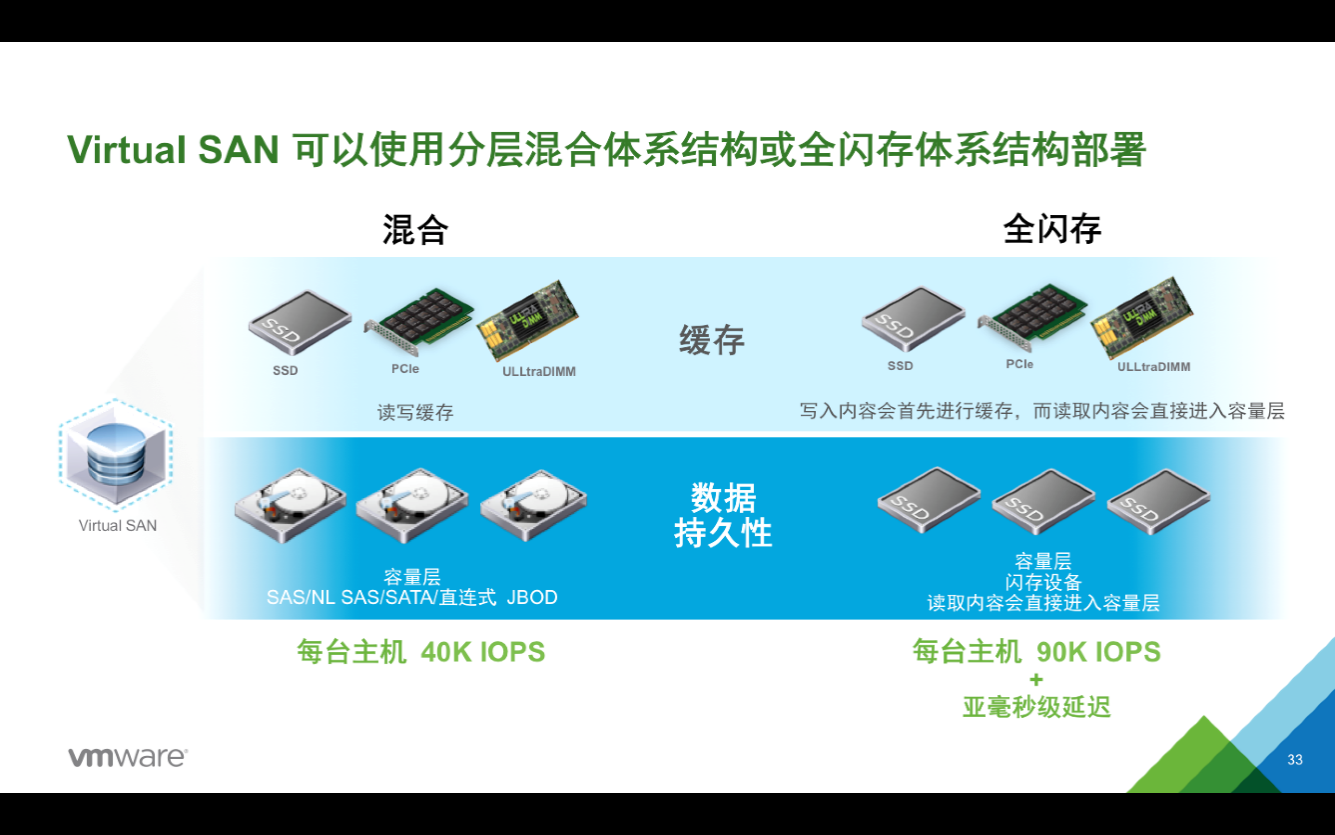

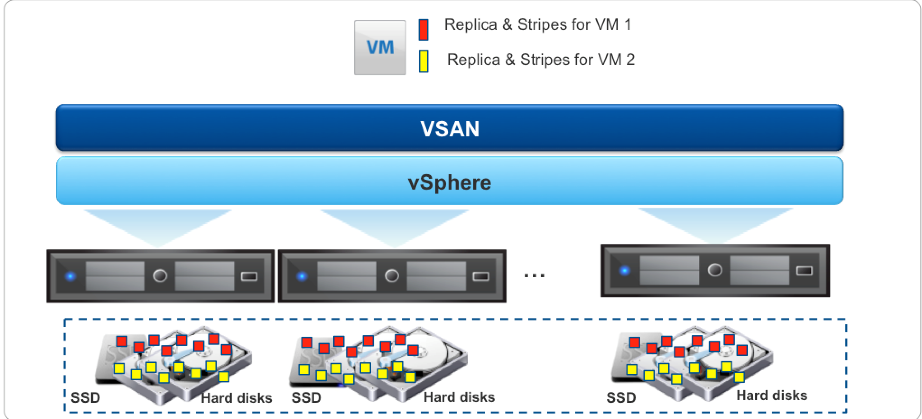

**超融合平台建设方案** **目 录** [**第1章 项目背景** 3](#_Toc15472680) [1.1建设背景 3](#_Toc15472681) [1.2超融合的价值 3](#_Toc15472682) [**第2章** **超融合方案设计** 5](#_Toc15472683) [2.1设计原则 5](#_Toc15472684) [2.2方案拓扑 7](#_Toc15472685) [2.3方案描述 8](#_Toc15472686) [2.4部署规划 9](#_Toc15472687) [2.4.1计算资源池 9](#_Toc15472688) [2.4.2存储资源池 9](#_Toc15472689) [3.2.2.1 磁盘控制器 10](#_Toc15472690) [3.2.2.2 硬盘驱动器 10](#_Toc15472691) [3.2.2.3 固态磁盘 10](#_Toc15472692) [3.3.3网络规划 11](#_Toc15472693) [3.3.3.1物理网络规划 11](#_Toc15472694) [3.3.3.2虚拟网络规划 12](#_Toc15472695) [2.5体系结构 12](#_Toc15472696) [**第3章** **方案优势** 17](#_Toc15472697) [4.1功能特性 17](#_Toc15472698) [4.2方案优势 20](#_Toc15472699) [**4.2.1简易性** 20](#_Toc15472700) [**4.2.2降低成本** 20](#_Toc15472701) [**4.2.3性能优势** 21](#_Toc15472702) [**第4章** **配置报价** 23](#_Toc15472703) 1. **项目背景** ## 1.1 建设背景 目前有多套业务系统,有SQL、ORACLE多个数据库。根据前期调研,国土局现有数据中心存在的挑战包括: • 服务器数量众多,管理变得越来越复杂; • 新业务系统上线周期长,部署慢; • SAN/NAS存储扩展性差,无法支撑新业务的性能需求; • 新业务走向互联网化,传统架构无法实现线性扩展能力; • 应用系统缺乏高可用性保护; • 数据中心空间资源有限等。 为了满足未来业务发展的需要,有效地解决数据安全、集中管控、降低运维成本、快速部署、跨平台访问、节能环保等问题,国土局一直在关注通过虚拟化、分布式及超融合等互联网相关技术来解决现有数据中心的各种挑战,随着虚拟化及云计算的日益成熟,计划将其数据中心新业务系统运行在的基于互联网基因的超融合基础架构平台上。 ## 1.2 超融合的价值 超融合基础架构(Hyper-Converged Infrastructure,或简称“HCI”)是指在同一套单元设备中不仅仅具备计算、网络、存储和服务器虚拟化等资源和技术,而且还包括备份软件、快照技术、重复数据删除、在线数据压缩等元素,而多套单元设备可以通过网络聚合起来,实现模块化的无缝横向扩展,形成统一的资源池。HCI是实现“软件定义数据中心”的终极技术途径。HCI类似Google、Facebook等互联网数据中心的大规模基础架构模式,可以为数据中心带来最优的效率、灵活性、规模、成本和数据保护。使用计算存储超融合的一体化平台,替代了传统的服务器加集中存储的架构,使得整个架构更清晰简单。 为什么把计算能力和存储能力融合在一起? 存储系统的本质,是以对空间的使用换取计算时间的缩短,网络的连接实现了空间与时间的转换。在经历过计算能力的大幅提升,网络能力的快速发展之后,存储能力成为了瓶颈。在研究更快、更高容量的存储介质,构建越来越庞大的存储集群的同时,利用计算能力、网络能力来弥补存储能力的不足也成为未来存储的一个发展方向。 在云计算和大数据时代,IT数据中心正从IDC向SDDC的趋势演变,生产形式也由辅助工具变成企业获取竞争力的主要源头。为了扩大业务规模,企业采用不同的选择,如融合和超融合基础架构。 相对于传统模式,超融合基础架构可以为用户带来巨大的价值: 1. 管理的便捷性。传统模式下运维以及需要做维护的时候,必须到数据中心里维护和操作,有了虚拟化之后,点几下鼠标就可以通过VMware或者通过其他虚拟化软件管理虚拟机或者是主机。 2. 虚拟化只解决了计算方面问题,但存储问题谁来解决?超融合是很简单的解决存储问题方式之一。超融合把计算和存储融合在一起,极大提高了便捷性。超融合采用分布式横向扩展架构,无论是扩充性能还是融合,通过横向扩展节点可以加速它的性能,加快它的容量,增长它的容量,这是横向扩展分布式带给大家的好处。 由此,本项目的基础架构层亦考虑采用超融合的方式进行建设。 1. **超融合方案设计** ## 2.1 设计原则 结合本项目的实际应用和发展要求,在进行方案设计过程中,应始终坚持以下原则: * **遵循主流技术体系** 遵循国际主要的云计算和大数据相关技术标准和事实标准,并采用当前主流的技术架构体系,与关键技术的长期发展方向保持一致性。通过统一的平台建设,提供接口式、可视化的能力,降低使用门槛,加速新技术的落地。 * **以共享为中心** 建设一个统一的大数据存储和计算平台,减少大数据基础环境的重复建设,降低成本,实现资源的高效利用,通过资源和数据的共享,激发更多的数据创新能力。 * **安全性** 平台提供安全、可靠的数据支撑能力,实现不同用户间的资源隔离,确保数据在平台中的安全与权限可控的使用。 * **系统可靠性** 系统要具有高可靠性及强大的容错能力。该系统必须保证 7×24 全天候不间断地工作,系统要具有全容错结构,主要物理设备需要支持热插拔功能,可带电修复有关故障而不影响整个系统的工作,设计应保持一定数量的冗余以保证整体系统的高可靠性和高可用性。即便是在系统建设初期也要着重考虑系统可用性、可靠性问题,防止出现系统停顿等问题造成信息系统的中断服务,从而提高系统的可靠性和可用性。 * **可管理性** 选择基于国际标准和开放的技术,采用标准化、规范化设计;同时采用先进的设备,易于日后扩展,便于向更新技术的升级与衔接,实现系统较长的生命力;保证市局在系统上进行有效的开发和使用,并为今后的发展提供一个良好的环境; 在设计、组建中心机房系统时,采用先进的、标准的设备;在选购服务器、存储和连接设备时,要确保系统部件间的严密配合和无缝联接,并获得良好的售后服务和技术支持;整个系统建成后按照整理一套完整的文档资料,以便提高整个系统的可管理性与可维护性。 * **可扩展性** 为保护已有的投资以及不断增长的业务需求,系统必须具有灵活的结构并留有合理的扩充余地,以便根据需要进行适当的变动和扩充;主要业务平台系统应采用开放的结构,符合国际标准、工业标准和行业标准,适应技术的发展和变化。 * **服务** 所采用的供应商必须具有相当实力支持快速、优质的技术支持和服务;从设计、实施到后续维护管理,全面协助用户的投资获得最大的效益,增加系统和应用的可用性,提高系统管理员的工作效率。 ## 2.2 方案拓扑  方案采用4台4U四路机架式服务器,通过低延时的万兆网络交换机搭建基于超融合架构的底层硬件平台从而为上层应用提供计算与存储服务。超融合架构采用基于VMware的软件平台(VMware vSphere + VMware vSAN)搭建集群,包含服务器虚拟化、分布式存储、软件定义网络等功能组件,可轻松实现对数据中心各类资源的统一管理与灵活调配。 相对于传统的物理设备搭建方式、虚拟化计算资源池+SAN存储搭建方式,超融合架构可提供管理侧单点登录、在一个管理平台里实现一站式运维,极大的降低维护成本与运维压力,从而减少了在运维中失误的可能性,为用户避免不必要的损失。 ## 2.3 方案描述 **超融合架构包含服务器虚拟化、分布式存储、软件定义网络等功能组件。**硬件架构上,采用4U服务器搭建,软件部分包含虚拟化平台和分布式存储两部分,选用基于VMware的软件平台(VMware vSphere + VMware vSAN)。 VMware在软件定义的存储方面的计划主要侧重于一系列围绕本地存储、共享存储和存储/数据服务的计划。从本质上来说,VMware希望使vSphere成为一个存储服务平台。软件定义的存储旨在通过主机上与底层硬件集成并对其进行抽象化处理的软件层,实现存储服务和服务级别协议的自动化。 软件定义的存储的一个关键因素是基于存储策略的管理(SPBM)。SPBM可以视为新一代VMware vSphere存储配置文件功能。SPBM是VMware实施软件定义的存储的一个关键要素。使用SPBM和VMware vSphere API,底层存储技术会呈现一个抽象化的存储空间池,为vSphere管理员提供用于虚拟机调配的各种功能。这些功能可能与性能、可用性或存储服务有关。然后,vSphere管理员即可使用虚拟机上运行的应用所需的部分功能创建虚拟机存储策略。在部署时,vSphere管理员可根据虚拟机的需要选择恰当的虚拟机存储策略。 SPBM会将要求向下推送至存储层。这时将启用多种数据存储以供选择,这些数据存储可提供虚拟机存储策略中包括的各种功能。这意味着系统将始终根据虚拟机存储策略中设置的要求,在恰当的底层存储上创建虚拟机实例。如果虚拟机的工作负载随时间推移发生变化,只需将具有能够反映新工作负载的最新要求的策略应用于虚拟机即可。  图:软件定义的存储 软件定义的存储通过纯软件实现了存储相关的三个层面的功能: 通过策略自动化消费存储资源:以虚拟机为中心的安置、保护和性能策略 基于虚拟化的不依赖于硬件的数据服务:以虚拟机为中心的快照、克隆、复制、备份 通过虚拟化管理程序提取出存储抽象层:以数据存储和VMDK形式使用的异构存储 ## 2.4 部署规划 ### 2.4.1 计算资源池 超融合平台计算资源池采用vsphere虚拟化平台,计算资源池规划的原则包括: 1. 规划集群规模时必须要考虑资源冗余,一般情况下CPU、内存和存储资源需额外规划10%-20%的资源,除此之外还需额外配置一个节点; 2. 配置节点数量需要大于等于3台,后期可根据业务规模量的提高灵活在线扩展,在生产环境中,单集群服务器节点最多可扩展至32台; 3. Virtual SAN至少需要VMware vCenter Server版本6.0以上。vCenter Server的Microsoft Windows版和VMware vCenter Server Appliance均可管理Virtual SAN。Virtual SAN通过 VMware vSphere Web客户端进行配置和监控,这同样需要VMware vCenter Server版本 6.0。一个Virtual SAN至少需要三台vSphere主机(其中每台主机均具有本地存储)以形成受支持的Virtual SAN集群。这样,集群才能达到至少允许一台主机、磁盘或网络发生故障的最低可用性要求。vSphere主机至少需要vSphere版本6.0。 根据以上计算资源池规划,以及本项目实际需求,本次规划配置4个硬件服务器节点,每个节点配置4颗CPU和512GB内存。 ### 2.4.2存储资源池 超融合平台存储资源池采用VMware VSAN分布式存储设计。 存储策略是分布式存储的核心功能。在了解虚拟机的存储要求后,可参照数据存储的功能来创建自定义的存储策略,以实现对业务的进一步优化部署。浪潮超融合可确保对于部署到数据存储的虚拟机至少分配一个虚拟机存储策略,而且在同一个环境中,用户可以对多个虚拟机对象创建多个不同的存储策略以适应不同类型或类别的要求。分配存储策略之后,系统会在创建虚拟机时将这些存储策略要求向下推送到分布式存储层,以满足性能和可用性要求。 #### 3.2.2.1 磁盘控制器 Virtual SAN集群中的每台vSphere主机均需要一个磁盘控制器。它可以是SAS/SATA主机总线适配器(HBA)或RAID控制器。不过,RAID控制器必须至少支持以下两种功能模式中的一种:直通模式或RAID0模式。直通模式,通常指JBOD或HBA模式,是VSAN推荐的配置,VSAN将会通过存储策略特性要求管理所有RAID配置。 #### 3.2.2.2 硬盘驱动器 在采用VSAN混合架构时,每台vSphere主机在加入Virtual SAN集群时均必须至少具有一块HDD磁盘,可以是SAS,NL-SAS或SATA磁盘。HDD构成Virtual SAN数据存储的存储容量。磁盘驱动器提供VSAN共享存储的存储容量。 根据本项目需求,本次配置每节点12块1.2T SAS硬盘,扣除磁盘损耗,每节点可提供约14.4T的大容量存储空间;**在采用双副本策略的情况下,4台超融合节点可提供约28.8T的实际可用存储空间。** #### 3.2.2.3 固态磁盘 在VSAN架构基于闪存的设备可同时用于缓存层以及持久的容量层。在混合架构的vSphere每个主机必须至少有一个基于闪存的缓存盘——SAS,SATA或PCI-E参与VSAN群集。基于闪存的设备提供既一个写缓冲区和读取高速缓存。 在全闪存架构的每个vSphere主机必须至少有一个基于闪存的容量盘——SAS,SATA或PCI-E标记为一个容量设备,同时必须至少有一个用于提升性能的闪存盘才能加入VSAN群集。虚拟VSAN全闪存架构是基于两层模型的性能和容量。 在混合结构,每个主机基于闪存设备的容量越大,用于提升I / O的缓冲越大,性能提升越高。此场景并不适用于全闪速的结构。 注意:在混合和全闪存架构,基于闪存的高速缓存设备不向分布式VSAN提供数据存储的整体容量。因为它们是用于读取和写入缓存,他们只计入VSAN缓存层或写入缓冲区。在全闪存架构基于闪存的设备标记为容量的设备组成的分布式VSAN数据存储的大小。 在本项目中,本次配置每节点4块480GB SSD固态硬盘,扣除磁盘损耗,最终可提供约1.8T的SSD高速存储空间**,4台超融合节点可提供约7.2T的实际高速存储空间。** **根据实际应用经验,高速存储空间容量(SSD)与实际可用的大容量(SAS或SATA盘)的容量比例不得低于1:10,否则对存储性能会产生一定影响;根据计算,本方案的SSD与SATA盘的比例为1:5,可充分满足前端业务系统对于数据存储的性能需求。** ### 3.3.3网络规划 #### 3.3.3.1物理网络规划 浪潮超融合架构中的网络规划如下: * **管理网络:**用于管理集群所需的网络传输通道,需要双千兆网络 * **虚拟机业务网络:**虚拟机之间内部通讯与外网访问网络流量的通道,一般需要双千兆网络,业务较多可考虑双万兆。 * **存储网络:**用于镜像存储、虚拟机的块设备存储的网络通道,以及存储集群内部数据同步的网络通道,必须双万兆。 因此超融合架构每个节点需至少配置四千兆和双万兆网口是最佳配置,管理网络,业务网络和存储网络可以在物理层面进行隔离。本次每个节点配置两个双万兆网口,在这种配置下,管理网络和业务网络将共用双万兆网络,这样管理网和业务网就需要在虚拟交换机层面上做隔离。包括两部分内容: * 管理网和业务网需划分不同的vlan以保证网络隔离; * 管理网和业务网需设置网络I/O控制(NIOC),NIOC可以保证为所有的端口组选择合适的流量和优先级配置以实现负载均衡,特别是当虚拟机进行热迁移时可能会占用大量的带宽。因此要求管理网和业务网均部署在的分布式虚拟交换机上,同时限制管理网的NIOC。 #### 3.3.3.2虚拟网络规划 虚拟化环境内的业务虚拟机想要与外网进行通信,亦或者与其他虚拟机进行通信,需要虚拟化环境内部交换机的支持。 浪潮超融合的虚拟网络规划主要包括两个部分,业务虚拟网络的规划以及隔离设计。实际上就是将业务网络在虚拟化层通过虚拟交换机分割成多个隔离的虚拟端口组。管理员可根据业务的实际情况,例如业务的数量,在虚拟交换机上创建多个虚拟端口组(虚拟交换机另一端连接业务网),确保所设计的虚拟网络的足够业务虚拟机使用即可(后续可根据业务扩展需要创建新的虚拟端口)。每个虚拟端口需配置一组IP池供虚拟机使用。与此相对应的,每个业务虚拟机需配置至少一个虚拟网卡用于连接虚拟网络端口。 ## 2.5体系结构 vSAN的体系结构如下图所示。  图:vSAN体系结构 对vSAN的主机、磁盘和网络等方面的配置说明如下所示。 集群配置中至少 3 台主机或 2 台主机加上数据中心见证组件 3 台主机都必须提供存储 建议主机都配置类似的硬件 **主机**: 最多可扩展为 32 台(生产环境中) **磁盘**: 本地连接的磁盘 混合式: 磁盘和闪存设备 全闪存: 仅限闪存设备 网络 1 GB 以太网或 10 GB 以太网(首选) “见证”组件(仅限元数据)在可用性决策中充当连接中断器 vSAN 可以使用分层混合体系结构或全闪存体系结构部署,可利用全闪存存储体系结构提供不少于9万IOPS/主机,或通过混合存储体系结构提供不少于4万IOPS/主机,如下图所示。  图:vSAN 可以使用分层混合体系结构或全闪存体系结构部署 vSAN的上述体系结构可实现富有弹性的性能和容量扩展,不再需要复杂的预测和大量的前期投入,具有如下特点。 弹性:按需增长或缩减 精细:添加单个节点或磁盘 无中断:不会导致应用停止运行 如下图所示。  图:vSAN富有弹性的性能和容量扩展 vSAN中的几个重要概念: 独立节点可靠阵列(RAIN) RAIN的含义是独立节点可靠阵列,与独立磁盘可靠阵列(RAID)相对。简单地说,RAIN意味着数据中心的环境现在可以承受vSphere主机(或主机中的组件,例如磁盘驱动器或网络接口)故障,并可继续为所有虚拟机提供完整功能。不过,需要注意一点,即虚拟机可用性现在通过使用虚拟机存储策略按具体虚拟机逐一定义。现在,vSphere管理员可以使用存储策略定义vSAN集群中的虚拟机能够容许多少个主机、网络或磁盘故障。如果选择在存储策略中将可用性功能设置为零,则主机或磁盘故障肯定会影响您的虚拟机可用性。 关于RAIN需要格外注意的另一点是,如果出现故障,无需将故障节点上的所有数据迁移至集群中的其他节点。凭借RAIN体系结构以及虚拟机存储策略的使用,虚拟机副本可保留在集群中的多个节点上。无需将故障主机上存储的数据撤出,因为数据已存在于集群中的其他位置。  图:针对可用性的SAN数据存储 如上图所示,虚拟机存储对象(虚拟机主目录、VMDK、增量、交换)可以分布在vSAN集群中的多个主机和磁盘内。虚拟机可以使用复制副本提供可用性,或使用条带提供HDD性能。对于独立节点仅包括虚拟机的部分数据,这种分布式结构增加了原有数据的可靠性。 仲裁和副本 副本是为虚拟机指定可用性功能时创建的虚拟机存储对象实例的备份。可用性功能决定了可创建的副本数量。在集群中出现主机、网络或磁盘故障时,此机制可使虚拟机使用一组完整的对象继续运行。仲裁是每个存储对象的一部分。它们不包含数据,而仅包含元数据。其作用是在vSAN集群中做出可用性决定时用作仲裁。仲裁在vSAN数据存储上占用大约2MB的空间用于存储元数据。注意:要使某个对象在vSAN中可访问,则其50%以上的组成部分必须可供访问。 固态磁盘的作用 固态磁盘(SSD)在vSAN中做为缓存层功能时具有两个作用:提供读缓存和写缓冲区。这可以显著提高虚拟机的性能。在某些方面,vSAN可以与市场上的大量“混合”存储解决方案相媲美,后者也是使用SSD和HDD存储组合以提高I/O性能,并具有基于低成本HDD存储进行横向扩展的能力。 读缓存的作用 读缓存可以保留经常访问的磁盘块的缓存。这可减少缓存命中时的I/O读取延迟。虚拟机中运行的应用实际读取的块可能并非位于运行虚拟机的同一vSphere主机上。为解决这一问题,vSAN会在vSAN集群中的vSphere主机之间分发缓存块目录。这使vSphere主机可以确定是否另一台主机具有不在本地缓存中的缓存数据。如果确实如此,则vSphere主机会通过互连线路从另一台主机上检索缓存块。如果缓存块不在任何vSAN主机中,则直接从HDD进行检索。 写缓存的作用 写缓存可用作非易失性写缓冲区。事实上,通过使用SSD存储来执行写入,还可以减少写入操作的延迟。由于写入的数据将进入SSD存储,因此自然需要确保在vSAN集群中的其他位置有数据副本。部署到vSAN的所有虚拟机都具有一项可用性策略设置,用于确保至少有一个额外的虚拟机数据副本可用,其中包括写缓存内容。 当客户操作系统(OS)中运行的应用启动写入之后,写入的数据将被并行发送到当前主机上的本地写缓存和远程主机上的写缓存。在确认写入前,写入的数据必须提交至上述两台主机上的SSD中。 这意味着如果某台主机出现故障,在vSAN集群中的另一块SSD上还有一份数据副本,因此不会发生数据丢失。虚拟机将通过vSAN互连线路访问另一个vSAN主机上的数据副本。 1. **方案优势** ## 4.1功能特性 VMware vSAN体现了VMware软件定义存储愿景,它在全面集成的直连磁盘解决方案中纳入基于策略的控制层、以应用程序为核心的服务以及虚拟数据层。VMware vSAN采用分布式架构,利用SSD实现高性能的读/写缓存,并利用硬盘实现高成本效益的数据长期保存。功能特性包括: * 与 vSphere 紧密集成 vSAN 内置在 vSphere 内核中,可以优化数据 I/O 路径,从而提供最高级别的性能,同时最大限度地减少对 CPU 和内存的影响。 * 全闪存或混合式体系结构 vSAN 可用于全闪存体系结构中,在这样的体系结构中服务器连接的闪存设备提供缓存和数据持久性容量,以实现始终如一的超高性能级别。或者,vSAN 可用于混合式配置中,在这样的配置中服务器端闪存设备进行池化以提供读/写缓存,而服务器连接的HDD提供数据持久性。 全闪存架构支持PCI-e设备的分层:一个写密集高持久性能层用于写和读密集的工作负载,一个经济有效的容量层用于数据持久的负载,从而减少全闪存架构的总体的开销。 vSAN 可利用基于服务器端闪存设备的内置缓存最大限度地缩短存储延迟。vSAN 6.6 的新优化功能可提供比以前高出最多 50% 的 IOPS。全闪存的 vSAN 能够 以每 GB 可用容量不到1美元的成本进行部署,比竞争对手的混合超融合解决方案成本低 50% 以上。 * 高级管理 vSAN Management Pack for vRealize Operations 提供一整套可帮助管理 vSAN的功能特性,包括跨多个集群的全局可见性、利用主动通知进行运行状况监 控、性能监控以及容量监控和规划。运行状况检查插件可对该管理包进行补充,用于执行包括HCL兼容性检查和实时诊断 在内的其他监控。 * 快照和克隆 全新的 vSAN 磁盘格式可实现超高效且可扩展的以虚拟机为中心的快照和克隆,支持每个虚拟机每个克隆支持多达 32 个快照。 * 精细的无中断纵向或横向扩展 通过向集群中添加主机(横向扩展)或向主机中添加磁盘 (纵向扩展,以增加容量),无中断地扩展存储容量并提高性能。 * 重复数据消除和压缩 基于软件的重复数据消除和压缩功能可优化全闪存存储容量,使数 据最多缩减至原来的 1/7,同时最大限度减少 CPU 和内存开销。 * 纠删码 纠删码功能最多可使可用存储容量提升 100%,同时可使数据的恢复能力保持不 变。借助单奇偶校验保护或双奇偶校验保护,它能够容许发生一次或两次故障。 * vSAN 加密 内置于 vSAN 的 vSAN 加密可提供集群级别的静态数据安全性,并支持 包括空间效率功能(如重复数据消除和压缩)在内的所有 vSAN 功能特性。vSAN 加 密只需单击几下即可启用,它针对合规性要求而构建,提供简单的密钥管理,并支持 所有符合 KMIP 标准的密钥管理器(如 CloudLink、Hytrust、SafeNet、Thales 和 Vormetric)。 * 具有本地保护能力的延伸集群 在两个地理位置不同的站点间创建具有站点保护和本地保 护的可靠延伸集群,并同步复制数据。它支持企业级可用性,可确保即使整个站点或本地 组件出现故障也不会丢失数据,并且几乎能够实现零停机。用户可基于每台虚拟机设置精 细保护并且可以无中断更改策略,所有成本相较于领先的传统解决方案降低 50%。 * 服务质量 (QoS) 现在所有版本的 vSAN 中都提供 QoS 控制,可限制并监控特定虚拟机 使用的 IOPS,消除邻位干扰问题。 * vSAN 运行状况服务 Health Service 可直接通过 VMware vCenter Server提供集成 硬件兼容性检查、性能监控、存储容量报告和诊断。 * iSCSI 访问 vSAN 存储可显示为物理工作负载的 iSCSI 目标。所有核心功能仍然可以通 过 vCenter 访问和管理。 * vSAN 云计算分析 vSAN 云计算分析通过提供实时支持通知和切实可行的建议,帮助确 保 vSAN 以最佳状态运行,从而减少监控以及进行故障排除的时间。此外,分析工具还可 以利用建议的设置针对某些场景进行性能优化。 * 双节点直连 通过取消双节点部署中两个服务器之间的交换机,每个站点可节省高达 20% 的成本。使用交叉电缆可以简单、可靠地直接连接服务器。 * 功能完备的 PowerCLI vSAN 包含一整套功能完备的 PowerCLI cmdlet,提供企业级 自动化的便利性和可扩展性。新的 SDK 和 API 更新通过支持 REST API,可提供更出色 的企业级自动化。 * 单一窗口管理 利用 vSAN,不再需要进行有关专门存储界面的培训,也无需在这些界面 上进行任何操作。调配现在只需单击两下,新的一键式硬件生命周期管理可将常见任务量 减少多达 80%。 * 以虚拟机为中心的基于策略的管理 vSAN 利用基于每台虚拟机应用的存储策略来自动调 配和平衡存储资源,从而确保每个虚拟机都能获得指定的存储资源和服务。 * 内置容错和高级可用性功能 vSAN 采用分布式 RAID 和缓存镜像,可确保在发生磁盘、主机、网络或机架故障时绝不丢失数据。它无缝支持 vSphere 可用性功能,如 vSphere Fault Tolerance、vSphere High Availability 等。适用于 vSAN 的 vSphere Replication可提供 RPO 最多仅 5 分钟的异步虚拟机复制。新的始终开启功能可独立于 vCenter 提供高度可用的管理体系,智能化重建功能可加速恢复。 ## 4.2方案优势 VSAN超融合是部署广泛、值得信赖的虚拟化基础架构平台。VSAN可为数据中心虚拟化带来横向扩展架构、高可用性和可靠性等优势。研究显示,并非所有的企业数据中心项目真正做到了全面部署,很大一部分项目通常因为基础设施的成本不断攀升而束之高阁。传统服务器和存储阵列扩展成为企业数据中心项目成本高昂、过程复杂并且难于实施的主要因素。从诸多数据中心项目实施来看,在企业环境中,性能、可靠性、可扩展性是关键,因为最终用户体验直接来自于基础设施的高性能和高可靠性。 VSAN将融合基础设施、横向扩展架构和软件定义存储的各种优势结合在一起,可提供极佳的数据中心虚拟化体验,而其成本仅为传统服务器和存储器的一小部分。VSAN完整集群是一种能够横向扩展的计算和存储基础设施,它使各组织机构无需存储网络(SAN或NAS)即可实现数据中心虚拟化。 **4.2.1简易性** Vmware专门为虚拟化而设计,能够提供全面的计算和存储能力,以及企业级的性能、可扩展性、可用性和数据管理功能。它采用英特尔芯片、固态硬盘等符合行业标准的硬件组件,以及市场领先的高级管理程序,以便提供开箱即用的解决方案,让数据中心虚拟化变得极其简单有效。 专为虚拟机设计的极其简单的存储—vSAN可以大大简化虚拟机的存储调配和管理。只需要直接在vSphere Web Client中单击几下即可快速完成存储调配。作为自行调节的系统,vSAN 可以根据每个虚拟机的要求进行自我优化,以提供适当的 SLA。 **4.2.2降低成本** 在性能相当的情况下,大幅降低总体拥有成本 —vSAN利用价格便宜的服务器磁盘和闪存、采用 vSphere标准网络连接、减少电源和散热成本并通过自动化提高运营效率,从而大幅度降低存储资本开销和运营开销。 凭借“随增长而扩展”功能降低前期投资—与传统存储阵列不同,vSAN不需要大量初始投资。您可以创建只包含三个服务器的vSAN数据存储。此外,vSAN还允许您更精细、更前瞻地扩展存储性能和容量,以配合计算资源的扩展。 **4.2.3性能优势** 使用Vmware虚拟化基础架构,在保证用户数据的高速访问和高可靠性同时,不再需要传统的集中式存储架构,避免在今后运行过程中出现设计初期忽视的性能问题。 VMware和广泛的体系支持—vSAN是一种纯软件解决方案,与硬件无关,可以在所有主流服务器OEM厂商的硬件上使用,不依赖专用硬件。  图:vSAN主要优势 因此,vSAN的主要优势可以总结为如下几点。 (1)通过与 VMware 环境轻松兼容的安全集成超融合解决方案,可将虚拟化技 术无缝扩展到存储领域。 使用现有管理工具、技能组合和您选择的 硬件平台 充分利用 VMware 行之有效的大型互补性 软件解决方案生态系统 使用业界首个原生 HCI 加密解决方案保护 数据 (2)降低 TCO: 通过将核心数据中心功能整合 到最广泛的行业标准 x86 硬件以及最成熟的 hypervisor 上,将有限的预算用到刀刃上, 并将总体拥有成本降低 50%。 将基础架构转变为低成本、高容量服务器 端经济优势 借助一个集成式软件体系简化管理 为经济实惠的站点保护部署强大、灵活的 延伸集群 (3)根据未来发展需求扩展规模: 借助软件定义的基础架构为迎接未来跨云时代的 IT 需求 做好准备。该基础架构利用最新硬件技术、 支持新一代应用,并且是通往云计算的重要 阶梯。 快速支持最新的硬件技术 专为现代企业级应用和容器而构建 专为多云时代的需求而构建的一个平台 1. **配置报价** **序号** **产品名称** **技术配置及其他要求** **单位** **数量** 1 超融合服务器 浪潮 NF8480M5 ★品牌:国有知名品牌,星号项为必须满足项;厂商是中国X86服务器市场主导品牌(需提供近两年内IDC发布的中国X86服务器半年度出货量排名第一或第二的有效证明); 架构:4U机架式服务器; 处理器:≥4 颗Intel Xeon GOLD-5118(2.6GHZ主频,12核心) CPU; ★内存:≥512 GB ECC DDR4内存,最大支持 48个内存插槽; ★硬盘:≥1块240GB SSD硬盘,4块480GB SSD硬盘,12块1.2TB 10K 2.5寸 SAS硬盘,前置支持24个2.5/3.5英寸硬盘,最大可支持12个U.2 NVMe硬盘,板载支持2个M.2硬盘,SATA/PCIE x2,并支持软RAID 0/1; RAID卡:配置8通道高性能SAS Raid 卡(1G缓存),支持RAID 0/1/5等; ★备份软件:配置原厂中文操作系统备份还原软件,并提供软件著作权证书及CMMI5证书; 网卡:≥4个高性能千兆网口,2个万兆网口(光纤接口含2个多模模块),一个千兆管理网卡,支持IOAT2高级网络加速功能,支持VMDQ网络虚拟化技术,支持网络唤醒、网络冗余、负载均衡等高级网络特性; 配件:机架安装导轨;1块TF CARD MICRO SD 8G; ★电源:≥2块铂金电源,单电源功率≥800W;支持3+1,2+2,2+1多种电源冗余方式; ★I/O扩展:最多支持16个PCIe3.0插槽+1个OCP插槽(提供官网链接与对应官网截图证明); ★管理功能:配置原厂中文服务器管理软件,并提供国家版权局软件著作权证书,支持远程管理控制,如IPMI2.0,KVM over IP (HTML5 /Java),SOL,SNMP,Redfish等,标配OLED液晶诊断屏; ★供应商资质:供应商拥有国家级服务器和存储重点实验室、服务器产品获得过国家科学进步一等奖,提供相关证明材料并加盖厂商公章; ★安全:支持原厂操作系统安全加固软件,提供软件著作权证书复印件与微软兼容性认证证书复印件; ★可靠性:支持同品牌双机热备软件并提供软件著作权复印件; 服务:提供完整的售前售中售后服务,售后要求三年原厂服务,拥有7×24小时的电话技术支持;投标时提供设备厂商工程师三年免费上门硬件保修服务承诺函及针对本项目的原厂授权。 台 4 2 超融合软件 **虚拟化平台:** 1.采用裸金属架构,无需绑定操作系统即可搭建虚拟化平台。Hypervisor结构精简,部署后所占用的存储空间在200M以下。 2.虚拟机之间可以做到隔离保护,其中每一个虚拟机发生故障都不会影响同一个物理机上的其它虚拟机运行,每个虚拟机上的用户权限只限于本虚拟机之内,以保障系统平台的安全性。 3. 虚拟机支持USB 3.0设备,支持3D显示卡虚拟化功能。虚拟机支持3D图形加速功能,可以根据需要启用或停用。 4. 提供HA功能,当集群中的主机硬件或虚拟化软件发生故障时,该主机上的虚拟机可以在集群之内的其它主机上自动重启。当虚拟机的客户操作系统出现故障时,可以自动重启该虚拟机客户操作系统,保障业务连续性。 5. 支持虚拟机的在线迁移功能,无论有无共享存储,都可以在不中断用户使用和不丢失服务的情况下在服务器之间实时迁移虚拟机,保障业务连续性。 6. 可确保在硬件出现故障时所有应用仍持续可用,而不会丢失数据或发生停机事件。针对最多 4 个虚拟 CPU 的工作负载。 7. 支持虚拟机级别的复制,从而可通过 LAN 或 WAN 高效复制任何类型的阵列上的虚拟机数据并简化管理。 8. 单根 I/O 虚拟化 (SR-IOV) 支持,允许将一个 PCI Express (PCIe) 适配器作为多个单独的逻辑设备提供给虚拟机。使用户能对 I/O 处理进行负载分流和降低网络延迟。 9. 每台虚拟化主机至少支持480颗逻辑CPU,要求提供官网链接。 10. 每个虚拟机的内存至少可以达到4TB,要求提供官网链接。 **云管理平台:** 1.支持单点管理,可以从单个控制台对所有虚拟机的配置情况、负载情况进行集中监控,并根据实际需要实时进行资源调整。 2. 控制台自身具备备份和还原机制,可以对数据进行备份和还原。 3. 每个控制台可管理至少1000台物理服务器、10000台已打开电源的虚拟机,15000台已注册的虚拟机,并可以通过链接至少10个控制台实例,跨10个实例管理30000个已打开电源的虚拟机和50000个已注册的虚拟机。 4.提供统一的图形界面管理软件,可以在一个地点完成所有虚拟机的日常管理工作,包括控制管理、CPU内存管理、用户管理、存储管理、网络管理、日志收集、性能分析、故障诊断、权限管理、在线维护等工作。同时能够直接配置、管理存储阵列,具有对存储阵列的多路径管理功能。支持QoS能力,支持基于应用程序的服务级别自动管理功能。 5. 可以支持Web Client和命令行管理功能。 **分布式存储:** 1. 分布式存储(Server SAN),支持多个独立的服务器本地SSD或磁盘组成一个可以共享的存储资源池。基于面向对象的存储架构,易于管理,并支持横向扩展 2. 嵌入虚拟服务器内核,深入了解虚拟机、应用、底层存储基础架构,缩短I/O数据路径降低延时,虚拟服务器的CPU资源占用更少,小于10%,与虚机的迁移、高可用、容错、分布式资源调度、无缝集成。 3. 在同一个图形界面里部署并管理计算和存储资源,并监控详细的性能与容量,支持Web界面。 4. 基于存储策略的管理,能够向上对接商业的vRealize Automation(vRA),和开源的OpenStack Cinder 5. 可实现以虚拟机为中心的快照和克隆,支持每个虚拟机不少于32个快照和克隆 6. 分布式存储管理软件支持的混合存储架构中,最大IO性能不少于4万IOPS/主机,200万IOPS/集群。 7. 针对每个VM可以设置高达4个副本,保证业务系统不间断运行。 8. 无缝集成虚拟化平台的HA、多核虚拟机Fault Tolerance、虚拟机在线迁移、存储在线迁移、自动化资源调度等功能,无需额外安装软件。 9. 可利用分布式RAID和缓存镜像来确保在发生磁盘、主机、网络或机架故障时绝不丢失数据。 10. 分布式存储管理软件最大可支持SSD磁盘数不少于320块,读写缓存支持动态扩展。 11. 分布式存储管理软件最大可支持虚拟机(VM)数不少于6400个。 12. 提供对计算、网络与存储资源的集中化管理界面,具备针对存储资源的硬件监控、合规性运行状况检查、容量规划和根本原因分析功能。 **服务及其他要求:** 1.超融合软件必须针对本次采购的所有超融合服务器提供完整授权。 2.超融合软件提供一年原厂商软件升级服务、在线支持服务、800电话支持服务,提供授权服务承诺函。 套 1 3 万兆网络交换机 1. 交换容量≥2.56Tbps,三层包转发率≥1080Mpps,转发延时≤800ns 2. 接口配置要求:≥48个固定10-Gbps SFP+端口,≥6个固定QSFP+端口 3. ★安全性:国产以太网交换芯片,自主安全可控,提供该芯片国产证明文件 4. 支持横向虚拟化技术,实现跨机箱的链路捆绑 5. ★支持SDN,openflow;支持VXLAN Routing and Bridging,NvGRE;支持Python 6. 实配支持Netflow/Netstream或sflow 7. ★所有物理端口可以直接配置为三层路由端口,配置IP地址;IPv4:支持静态路由,RIPv2,OSPFv2,BGP;IPv6:支持静态路由,OSPFv3,PIM-SMv6,Static Tunnel/ISTAP Tunnel/6to4 Tunnel; 8. 电源:实配可热插拔的冗余交流电源,支持4KV电压过载保护 9.本次配置:8个万兆多模模块,1根虚拟化线缆 台 2 4 接入交换机 1、24口全千兆接入层以太网交换机 2、下行:24个10/100/1000Base-T以太网端口,上行:4个千兆SFP 3、交流供电 4、包转发率≥42Mpps 5、交换容量≥68Gbps 台 15 5 维护工具 联想E75Yi7700,32G内存+512G+2TB双固态硬盘,1050Ti显卡,华硕RT-AC86U无线路由器 套 1 6 备份工具 希捷(Seagate) 4TB USB3.0 移动硬盘 睿翼 2.5英寸 个 2

胡文龙

2023年11月1日 10:43

转发文档

收藏文档

上一篇

下一篇

手机扫码

复制链接

手机扫一扫转发分享

复制链接

Markdown文件

Word文件

PDF文档

PDF文档(打印)

分享

链接

类型

密码

更新密码

有效期