SAP-basis相关文档

SAP语言包安装说明

basis学习记录

SAP HANA数据库HA双机架构概念及运维

慢sql查询优化解决方法

SAP 760 客户端安装手册

PO系统日志目录NFS共享

Solution Manager监控配置oracle操作手册

SOLution-Manager-监控配置安装SAP VER环境_李光升

SAP Business One FOR linux 安装教程

SAP 760 GUI 安装访问异常问题分析

SAP Business One FOR HANA 安装

什么是 SAP Business One(SAP B1)

SAP MC/JSmon/Configtool监控配置文档

SAP B1安装文档

PO日志系统磁盘扩容

SAP系统卓创证书更新

新建集团和集团拷贝

SAP HANA自动备份和清理配置操作

HANA slt 同步数据至ORACLE

fico-生产订单的生命周期过程

HANA数据库License申请文档

S4D300client发版至S4D510Cclient改动说明

SAP禁用过期账号

SAP打补丁操作步骤

SUSE 15安装手册

RDS系统恢复演练

suse 磁盘在线扩容操作手册

HANA 性能分析SQL

SAP证书安装操作记录

SAP归档系统配置手册

SAP gui 760客户端安装文档

SAP 调度作业管理制度

新SAP单点windows登录操作手册

新SAP系统mac登录操作手册

AMS系统windows登录手册

AMS系统mac登录SAP手册

HANA磁盘在线扩容-字符方式

2952296-用于数据提供(dpserver)的许多开放内部连接

PO一体机接口卡顿问题分析

PO互备模式

SAP BASIS培训试题

LDAP服务器停掉PO无法启动

SAP用户权限管理

B1重启问题分析ip addr add 10.7.4.52/24 dev eth0

IMM远程管理卡产品学习手册

POSTGre 数据库安装操作

SAP 正式环境COPY到400后需要调整的内容–PO配置

ERP二维码配置生产环境问题

PO系统证书操作手册文档20240815

ABAP基础知识

SAP HANA 内存原理

PO之过期消息的删除

SAP 邮件发送功能配置

用户存在角色却提示无权限的处理方法

hana数据库新建用户及表授权

Linux cached持续增大:原因和解决方法

ProtoReasoning:为大模型推理能力的提升注入新动力

什么是Web Dispatcher

hana数据库的磁盘碎片化整理操作手册

什么是LORA模型

清理HDS数据库中表SXMSCLUP

申请license步骤

国产GLM-4.6编程模型海外“出圈”,成全球开发者新宠儿

HANA数据库版本升级

NVIDIA 推出 Orchestrator\-8B:高效工具和模型选择的强化学习控制器

本文档使用「觅思文档专业版」发布

-

+

首页

什么是LORA模型

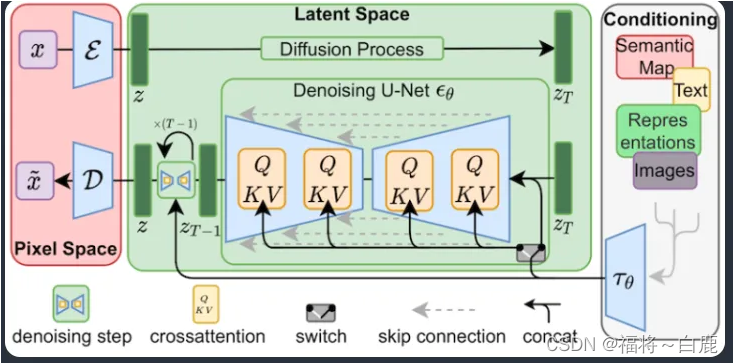

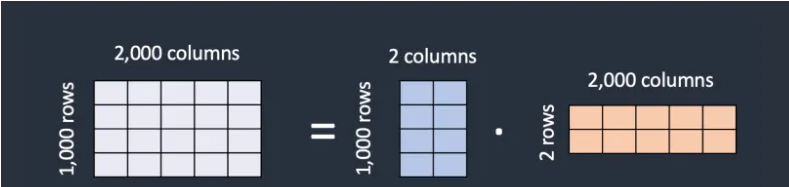

**LoRA 模型** LoRA模型,全称Low\-Rank Adaptation of Large Language Models,是一种用于微调大型语言模型的低秩适应技术。它最初应用于NLP领域,特别是用于微调GPT\-3等模型。LoRA通过仅训练低秩矩阵,然后将这些参数注入到原始模型中,从而实现对模型的微调。这种方法不仅减少了计算需求,而且使得训练资源比直接训练原始模型要小得多,因此非常适合在资源有限的环境中使用。12 在Stable Diffusion(SD)模型的应用中,LoRA被用作一种插件,允许用户在不修改SD模型的情况下,利用少量数据训练出具有特定画风、IP或人物特征的模型。这种技术在社区使用和个人开发者中非常受欢迎。例如,可以通过LoRA模型改变SD模型的生成风格,或者为SD模型添加新的人物/IP。1 LoRA模型的使用涉及安装插件和配置参数。用户需要下载适合的LoRA模型和相应的checkpoint模型,并将其安装到相应的目录。在使用时,可以将LoRA模型与大模型结合使用,通过调整LoRA的权重来控制生成图片的结果。LoRA模型的优点包括训练速度快、计算需求低、训练权重小,因为原始模型被冻结,我们注入新的可训练层,可以将新层的权重保存为一个约3MB大小的文件,比UNet模型的原始大小小了近一千倍。2 总的来说,LoRA模型是一种高效、灵活且适用于多种场景的模型微调技术,它在保持原始模型性能的同时,允许用户根据需要进行定制化调整。 **深入剖析LoRA 模型** 什么是 LoRA 模型以及如何使用它 LoRA 模型是一种Stable Diffusion模型的小型模型,通过对标准检查点模型进行微小更改来实现。它们的大小通常比检查点模型小 10 到 100 倍,这使得它们对于拥有大量模型的人非常有吸引力。 什么是 LoRA 模型? LoRA(Low\-Rank Adaptation)是一种用于微调Stable Diffusion模型的训练技术。 但我们已经有了其他的训练技术,例如 Dreambooth 和 文本反转。那么 LoRA 有何特别之处呢?LoRA 在文件大小和训练能力之间取得了良好的平衡。Dreambooth 功能强大,但模型文件体积较大(2\-7 GB)。文本反转模型很小(约100 KB),但功能有限。 LoRA 位于二者之间:它们的文件大小适中(2\-200 MB),而且训练能力还不错。 那些喜欢尝试各种 模型 的Stable Diffusion用户可以告诉你,他们的本地存储很快就会填满。由于文件体积较大,用个人电脑来维护一个模型集合非常困难。LoRA 是解决存储问题的绝佳方案。 与文本反转类似,你不能单独使用 LoRA 模型。它必须与模型检查点文件一起使用。LoRA 通过对附带的模型文件应用小的改动来修改风格。 **LoRA 是如何工作的?** LoRA 对Stable Diffusion模型中最关键的部分进行微小改动:交叉注意力层。这是模型中图像和提示相遇的部分。研究人员发现,仅微调模型的这一部分就足以实现良好的训练效果。交叉注意力层在下方的Stable Diffusion模型架构中以黄色部分表示。  交叉注意力层的权重被排列成矩阵形式。矩阵就像 Excel 电子表格中按列和行排列的一系列数字。LoRA 模型通过将其权重添加到这些矩阵中来对模型进行微调。 LoRA 模型文件如何更小,即使它们需要存储相同数量的权重?LoRA 的技巧在于将矩阵分解为两个较小(低秩)的矩阵。这样可以存储更少的数字。我们通过以下示例来说明这一点。 假设模型有一个具有 1,000 行和 2,000 列的矩阵。这就是要在模型文件中存储的 2,000,000 个数字(1,000 x 2,000)。LoRA 将该矩阵分解为一个 1,000x2 的矩阵和一个 2x2,000 的矩阵。这只需要 6,000 个数字(1,000 x 2 \+ 2 x 2,000),是原始矩阵大小的 333 倍。这就是 LoRA 文件更小的原因。  LoRA 将一个大矩阵分解为两个小的低秩矩阵。 在这个示例中,矩阵的秩是 2。它远远低于原始维度,因此被称为低秩矩阵。秩可以低至 1。 但是,这样做是否会产生任何问题?研究人员发现,在交叉注意力层中进行这样的操作并不会对微调的效果产生太大影响。因此,我们是安全的。

谢志成

2025年9月28日 11:33

转发文档

收藏文档

上一篇

下一篇

手机扫码

复制链接

手机扫一扫转发分享

复制链接

Markdown文件

Word文件

PDF文档

PDF文档(打印)

分享

链接

类型

密码

更新密码

有效期